Critères de référencement naturel en 2016 d’après Searchmetrics

Searchmetrics a publié son rapport annuel et approfondi sur les facteurs de référencement de Google, le leader des moteurs de recherche. Searchmetrics effectue cette analyse depuis 2012, toutefois, les résultats de 2016 différent de ceux qui ont été découverts les années précédentes. Google définit cela comme une liste d’aspects SEO à respecter et a ainsi commencé à adopter une approche plus sophistiquée en matière de référencement naturel. À l’avenir, le rapport de l’étude menée comprendra une analyse plus approfondie et divisée en plusieurs catégories.

Ces différences sont liées entre autres au système d’intelligence artificielle de Google, nommé RankBrain (littéralement, « cerveau de référencement »). Ce système agit de manière bien plus flexible que les algorithmes de recherche traditionnels. C’est en juin 2016 qu’un des salariés de Google, Jeff Dean, a initié ce changement de mode opératoire du moteur de recherche.

L’étude actuelle, nommée « Ranking factors – rebooting for relevance » présente Searchmetrics comme un catalogue réunissant les facteurs de référencement principaux des moteurs de recherche. Les résultats obtenus doivent être interprétés comme des analyses spécifiques liées à différents secteurs. L’étude de 2016, tout comme celle de l’année précédente, s’appuie sur un ensemble de 10 000 mots-clés pertinents pour les moteurs de recherche. Découvrez ci-dessous les principaux résultats de l’étude actuelle menée par Searchmetrics.

Le contenu en guise de facteur principal de référencement

Searchmetrics a renforcé son constat en ce qui concerne l’importance du contenu, au vu des toutes dernières modifications dans l’algorithme de Google. Le contenu d’un site Web et notamment sa pertinence doit donc être au centre de l’optimisation pour les moteurs de recherche, notamment depuis 2016. En revanche, l’importance de l’optimisation en fonction de mots-clés uniques prend du recul par rapport au contenu.

La pertinence du contenu en tant que critère déterminant pour le référencement

Un contenu de qualité se distingue par le fait qu’il corresponde aux nouvelles attentes des utilisateurs. Ces attentes divergent néanmoins d’une requête à l’autre. Les créateurs de contenu dans un objectif marketing font face au défi de tenter de réunir le plus de requêtes possibles dans un même texte. Dans le cadre d’une stratégie de création de contenu, les textes sont avant tout à caractère holistique et englobent plusieurs aspects dans un même thème. En ce qui concerne les mots-clés, ils diffèrent les uns des autres mais leur sémantique appartient à un même champ lexical et thématique. Le contenu holistique a donc pour objectif d’obtenir un bon référencement naturel pour plusieurs mots-clés pertinents.

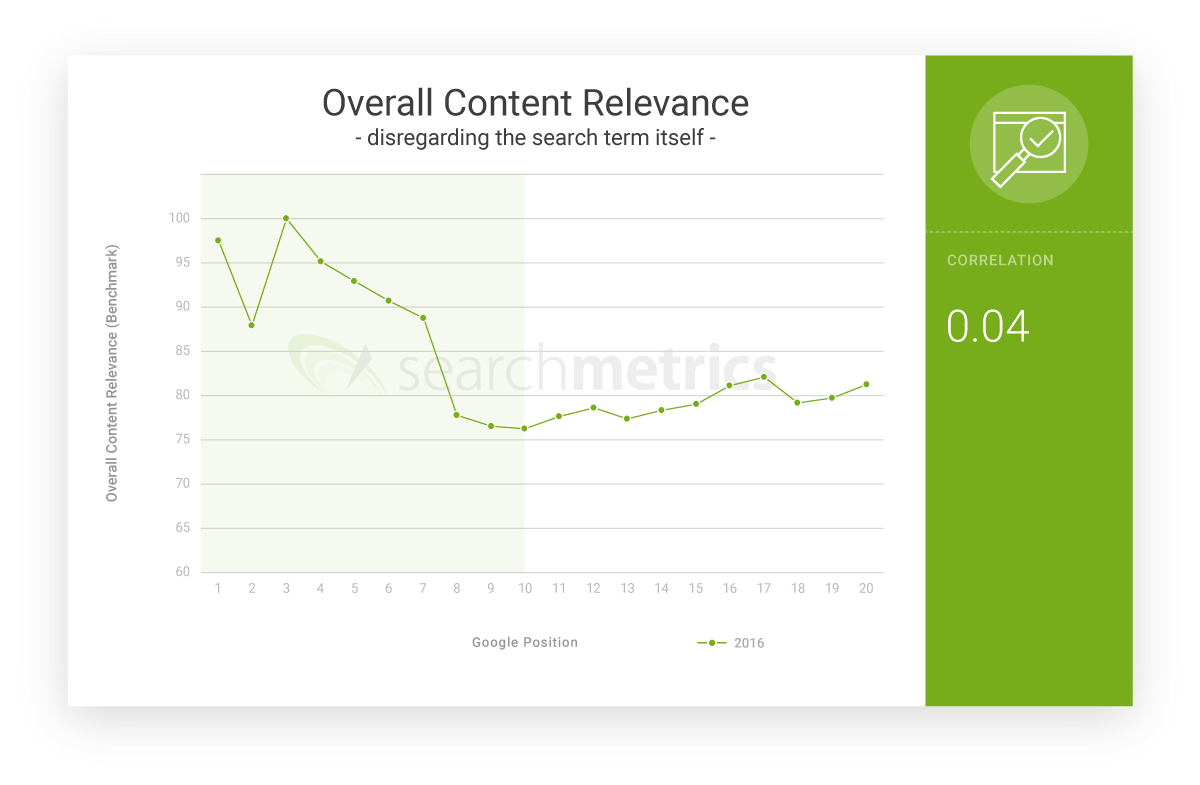

Dans le cadre de l’étude de Searchmetrics, la qualité du contenu d’un texte est analysée en fonction de sa pertinence par rapport aux mots-clés. C’est lié à un corpus linguistique et aux liens sémantiques. Le résultat est peu surprenant :

« Les URLs avec le contenu le plus pertinent occupent les places 3 à 6 »

Le score de pertinence pour les résultats de recherche suivants décroît de manière constante. La première et la deuxième position doivent être considérées séparément dans le cadre de cette étude. Selon Searchmetrics, ces places sont généralement occupées par des sites Web de marques connues. Ces sites bénéficient de facteurs comme le degré de popularité, la confiance des utilisateurs et l’image de marque. C’est pourquoi leur positionnement parmi les résultats de recherche n’est pas systématiquement lié à la qualité et la pertinence du contenu.

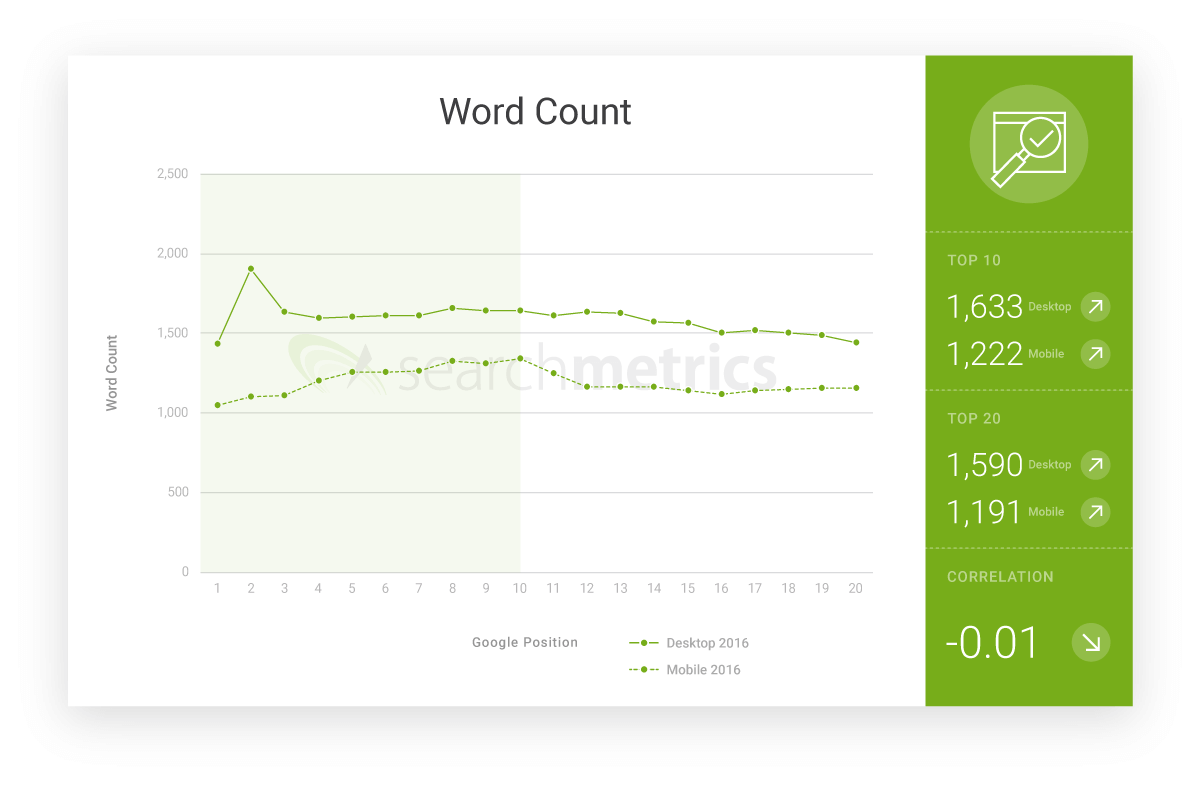

Le nombre de mots en moyenne augmente

Le nombre de mots en moyenne pour les pages d’atterrissage bien référencées augmente constamment depuis plusieurs années. Selon Searchmetrics, cela reflète une volonté de favoriser une approche holistique, plutôt que différents thèmes.

« Le nombre de mots en moyenne a augmenté de 50 pourcent en 2016 »

Les principales différences relevées en ce qui concerne le nombre de mots moyens sont observables en comparant les contenus de pages d’atterrissage desktop et mobiles. Selon l’étude qui a été menée, les versions desktop d’un site Web sont généralement 30 pourcent plus longues que les versions mobiles.

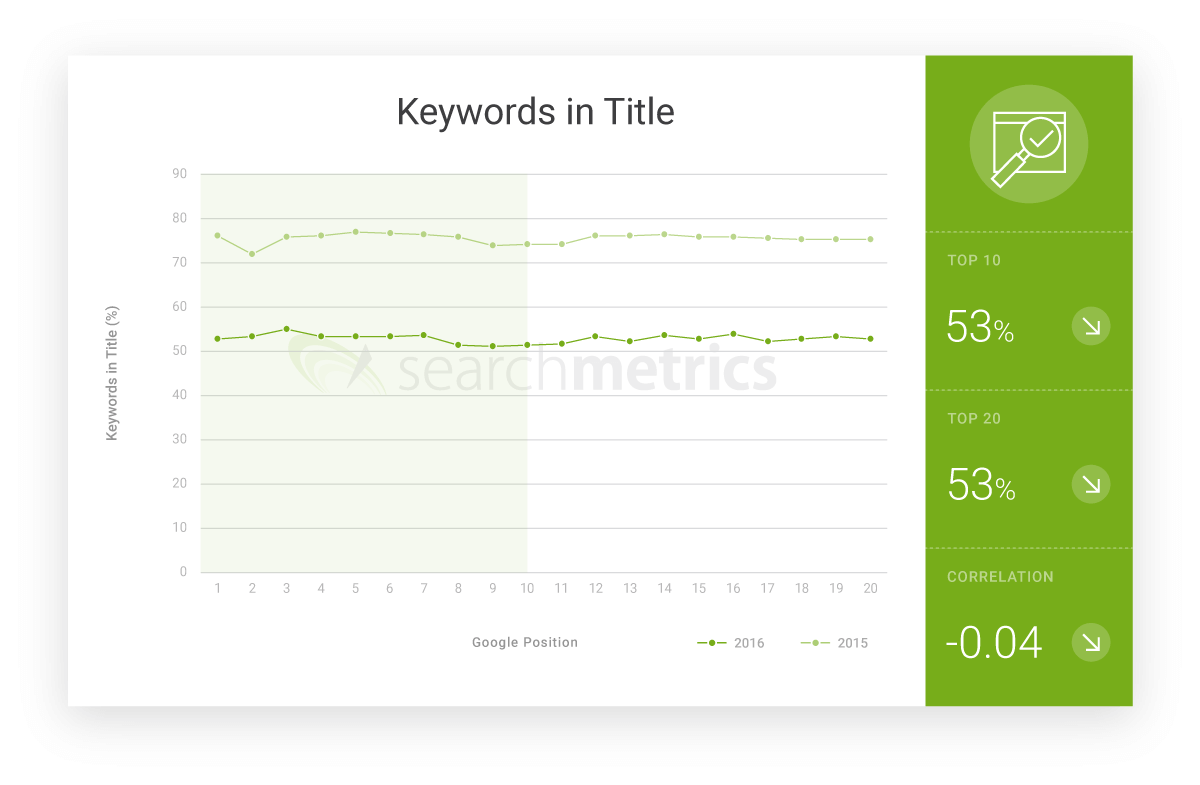

Le mot-clé utilisé dans le titre perd en importance

Parmi les professionnels du référencement naturel, l’utilisation du mot-clé dans le titre est toujours incontournable et devrait de préférence être placé en début de phrase. Néanmoins, les résultats de l’étude de Searchmetrics démontrent le contraire :

« En 2016, seulement 53 pourcent des premiers 20 URLs référencés ont un titre dans lequel figure le mot-clé »

Ce changement s’explique par le fait que la nouvelle approche holistique de la création de contenu est orientée vers une optimisation en fonction de thèmes et non en fonction de mots-clés. Le système d’intelligence artificielle de Google est depuis capable d’analyser des ensembles sémantiques dans leur globalité sans être influencé par les mots-clés contenus.

De manière comparable, ce changement est observable également en ce qui concerne les descriptions et les titres. Selon Searchmetrics, encore un tiers des 20 premières pages d’atterrissage comptent un mot-clé dans le titre principal (H1).

Les signaux des utilisateurs

Afin de déterminer si les utilisateurs de Google sont satisfaits des URLs proposés parmi les résultats de recherche, l’entreprise de la Silicon Valley ne peut pas se baser uniquement sur des facteurs indirects comme l’analyse sémantique des contenus des sites Web. En plus du moteur de recherche, les produits de Google livrent des informations détaillées sur le comportement des internautes, comme le navigateur Chrome, l’extension Analytics ou encore la régie publicitaire AdWords.

Pour établir si un site Web offre réellement ce qu’il propose, Google analyse les signaux des utilisateurs, par exemple le taux de clics et le taux de rebond, tout comme le temps de visite moyen. D’autres facteurs provenant des bases de données sont également pris en compte et analysés en temps réel pour établir le référencement sur le moteur de recherche. Ici aussi, l’analyse de Searchmetrics apporte une contribution pertinente aux connaissances des administrateurs de sites Web et aux experts en référencement naturel.

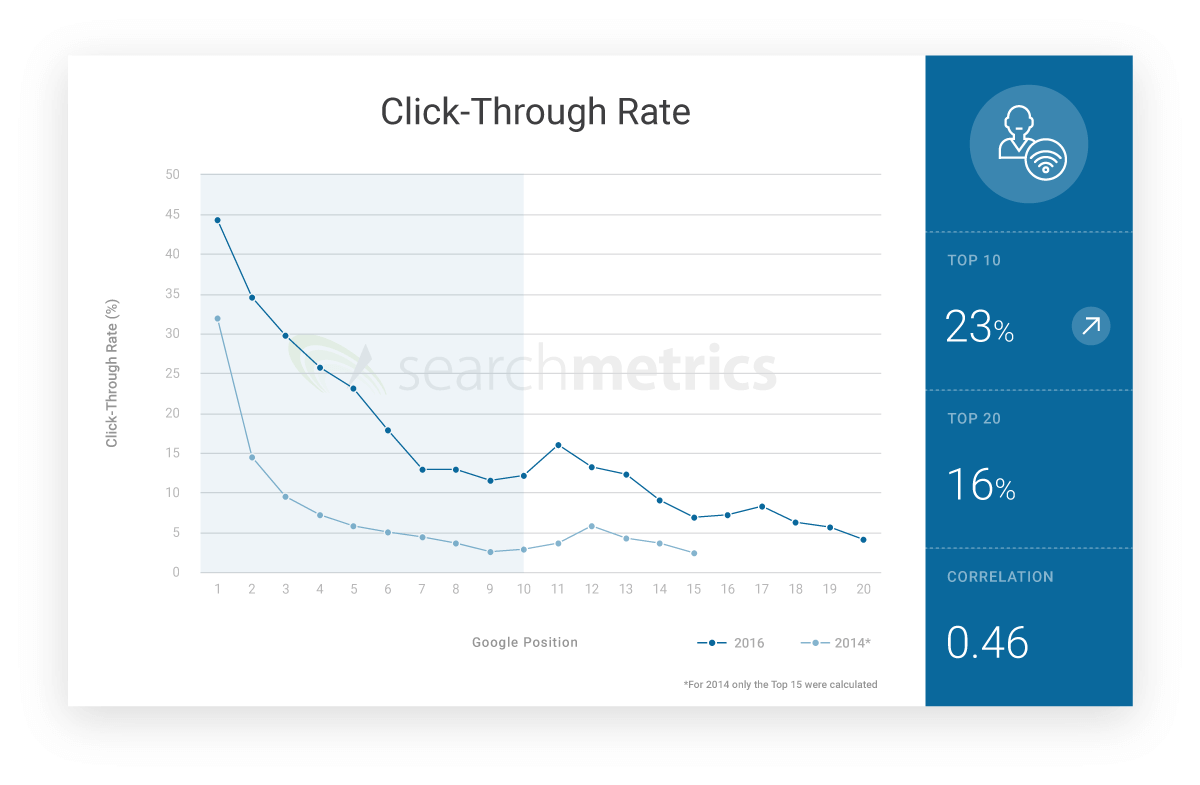

Le taux de clic moyen des éléments 1 à 3 est de l’ordre de 36 pourcent

La confiance des utilisateurs dans l’estimation de la pertinence des contenus proposés par Google est élevée. C’est ce que démontre l’étude de Searchmetrics depuis 2014, dans laquelle le taux de clics (Click-Through-Rate, CTR) des URLS les mieux référencés a été dévoilé. Les sites Web positionnés sur la première place sont ceux qui obtiennent le plus de clics. L’équipe de Searchmetrics a estimé dans ses calculs un taux de clics moyen de 44 pourcent pour les sites en première position. Ce pourcentage chute à 30 pourcent dès la troisième position.

« Le CTR moyen pour les positions 1 à 3 est estimé à 36 pourcent.

Il est clairement observable que le taux de clics prend de l’importance à partir de la onzième position. La première page d’atterrissage sur la deuxième page de résultats de recherche obtient en moyenne plus de clics que les pages d’atterrissage figurant à la fin de la première page de résultats de recherche. Comparé à l’année 2014, le taux de clics moyen des 10 premiers URLs dans le classement de Google est en nette augmentation.

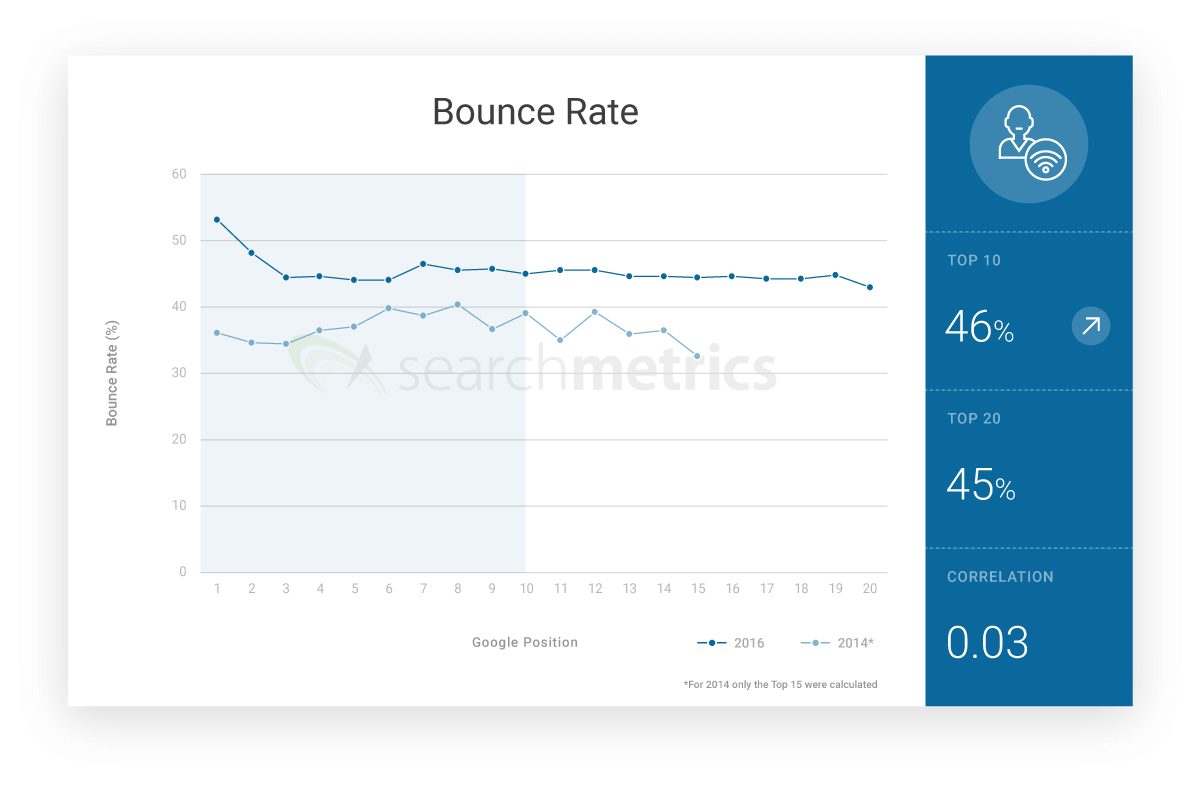

Le taux de rebond parmi la première page de résultats augmente de 46 pourcent

En plus du taux de clics, la pertinence d’un site Web est également évaluée à partir du taux de rebond (Bounce Rate). Ce chiffre montre combien d’utilisateurs quittent un site Web sans consulter d’autres pages de ce même site. L’équipe de Searchmetrics responsable de l’étude a déterminé que parmi les URLs inspectés, 46 pourcent des dix premiers d’entre eux affichent un taux de rebond supérieur à ceux mesurés en 2014. L’écart le plus important est observable entre la position 1 et 2.

Selon les analystes, le taux de rebond n’est pas un critère de référencement déterminant de la pertinence d’un site Web. Le fait qu’un internaute quitte un site Web sans consulter d’autres pages de ce même site peut être expliqué par exemple par le fait que l’internaute ait pu obtenir toutes les informations qu’il cherchait sur cette même page qu’il a consultée. Ainsi, l’internaute n’a pas besoin de poursuivre ses recherches. Ce cas de figure s’observe avant tout lorsque les internautes effectuent une recherche à caractère purement informatif.

Pour expliquer l’augmentation du taux de rebond moyen, l’équipe de Searchmetrics s’appuie sur l’efficacité de l’algorithme de Google. Grâce au nouveau système d’intelligence artificielle, le moteur de recherche est désormais en mesure de déterminer très précisément quels sont les résultats de recherche qui correspondent au plus près à la requête des internautes. Par conséquent, il arrive de plus en plus rarement que les internautes aient à consulter plusieurs sites pour obtenir les informations qu’ils recherchaient.

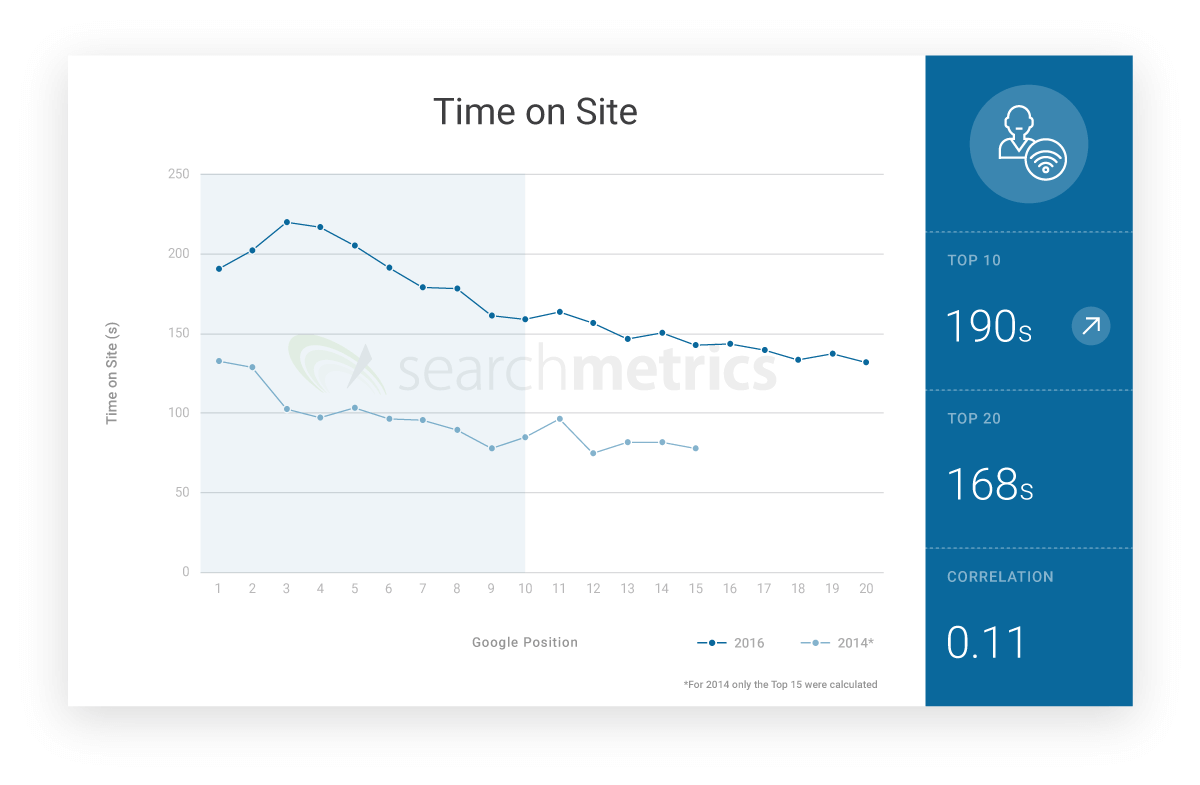

Le temps de visite moyen augmente

Un des éléments les plus importants pour déterminer la pertinence d’un site Web repose sur le temps de visite des internautes, c’est-à-dire le temps écoulé entre le moment où celui-ci clique sur le site et le moment où il quitte le site Web. Le Time on Site, ou temps de visite, peut être mesuré de manière très précise grâce à Webanalytics. Searchmetrics présente une valeur moyenne qui peut être interprétée de différentes manières.

« Le temps de visite moyen sur un site Web parmi les 10 premiers URLs référencés s’élève à 3 minutes et 10 secondes. »

En comparant cette valeur avec celle qui a été mesurée en 2014, il est possible d’observer une augmentation du temps de visite moyen sur les 10 premiers URLs référencés. Ce développement peut s’expliquer par le fait que les administrateurs de sites Web qui souhaitent soigner leur référencement naturel sur Google se voient contraints de proposer un contenu de qualité s’ils veulent réussir.

Bien qu’un temps long de visite soit un indicateur de qualité, cela ne signifie pas forcément in fine qu’un temps de visite court est synonyme de contenu de qualité moindre. Comme mis en lumière précédemment, il arrive que la page d’un site Web comprenne toutes les informations que l’internaute recherche et que celui-ci n’ait pas besoin de rester longtemps sur le site (par exemple si le visiteur souhaite simplement consulter la météo ou le résultat d’un match de football)

Facteurs techniques et convivialité d’utilisation

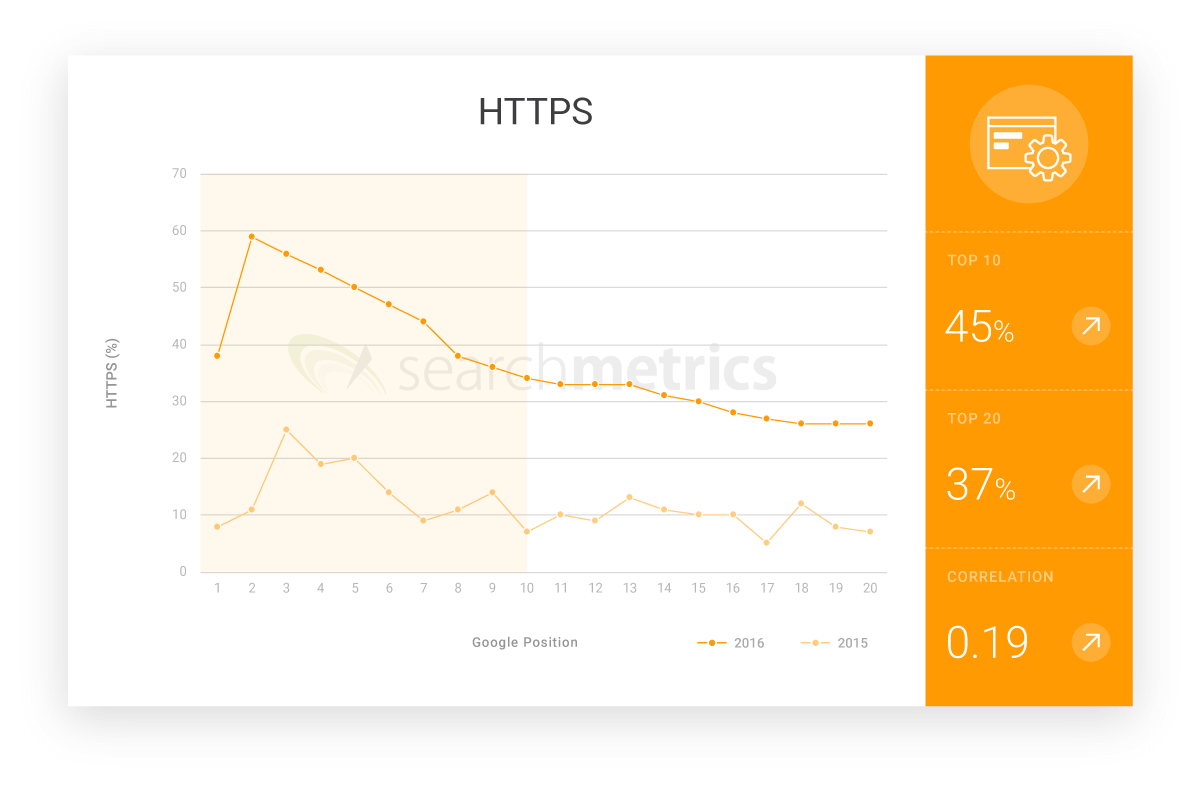

La création d’un contenu de qualité qui propose une réelle valeur ajoutée aux visiteurs n’est qu’un des piliers de l’optimisation pour les moteurs de recherche. Même un site qui comprend le meilleur des contenus ne pourra pas atteindre les premières positions parmi les résultats de recherche. Car pour atteindre les premières positions, certaines conditions techniques doivent être respectées. Les sites Web modernes doivent répondre aux critères suivants : performance, sécurité, convivialité d’utilisation. En plus de respecter certains aspects techniques, 2016 a dessiné de grandes tendances, comme le raccourcissement du temps de chargement ou encore de la taille des données. La principale tendance observée en 2016 parmi les critères de référencement est également l’optimisation des sites Web en version mobile. Searchmetrics souligne de plus l’importance croissante du cryptage sécurisé en HTTPS pour le référencement naturel sur les moteurs de recherche.

HTTPS sera incontournable à partir de 2017

Les webmasters qui renoncent au cryptage des données via HTTPS rencontreront des difficultés croissantes face à l’optimisation naturelle de leur site Web, comme l’a annoncé Google en septembre 2016. Les sites HTTP, sur lesquels des données sensibles sont travaillées, seront indiqués clairement comme étant « non sécurisé » auprès des internautes à partir de 2017. Il n’est pas nécessaire d’être devin ni expert en SEO pour anticiper l’impact d’un tel avertissement sur le taux de clic des visiteurs sur les sites non sécurisés. C’est pourquoi les experts constatent une augmentation constante des sites Web sécurisés en HTTS. S’il n’y avait que 12 pourcent des 10 premières pages d’atterrissage qui misaient sur HTTPS l’année précédente, Searchmetrics a évalué ce nombre à 45 pourcent en 2016.

« Presque la moitié des sites Web du top 10 utilisent désormais un cryptage HTTPS. »

L’optimisation pour mobiles, pilier pour un bon référencement naturel

Les recherches sur le Web effectuées à partir d’un support mobile ne cessent d’augmenter. Selon un rapport mené par Google en 2015, il y a plus de requêtes qui ont été effectuées sur des supports mobiles aux États-Unis et au Japon que sur des ordinateurs classiques. L’influence que prend ce facteur en matière de référencement naturel sur les moteurs de recherche est indéniable depuis que l’approche « mobile first » de Google a été dévoilée en octobre 2016. Pour les webmasters qui ne prennent pas encore en compte les mobinautes, ou utilisateurs mobiles, l’approche mobile de leur site Web devrait être hissée en haut de leur agenda pour 2017. Pour favoriser l’aspect mobile friendly d’un site Web, il convient d’opter pour un design responsif ainsi qu’une présentation dynamique, entre autres.

Signaux sociaux

Tout comme l’étude de Searchmetrics l’a déjà indiqué en 2014, une forte corrélation a également été observée en 2016 entre un excellent référencement naturel et les signaux sociaux. Il s’agit là de signaux de communication comme des partages, des mentions « j’aime » et des commentaires sur les réseaux sociaux comme Facebook, Twitter, Pinterest ou Google+. La parallèle entre un bon référencement naturel et une présence réussie sur les réseaux sociaux reste toutefois difficile à établir pour les spécialistes et les analystes.

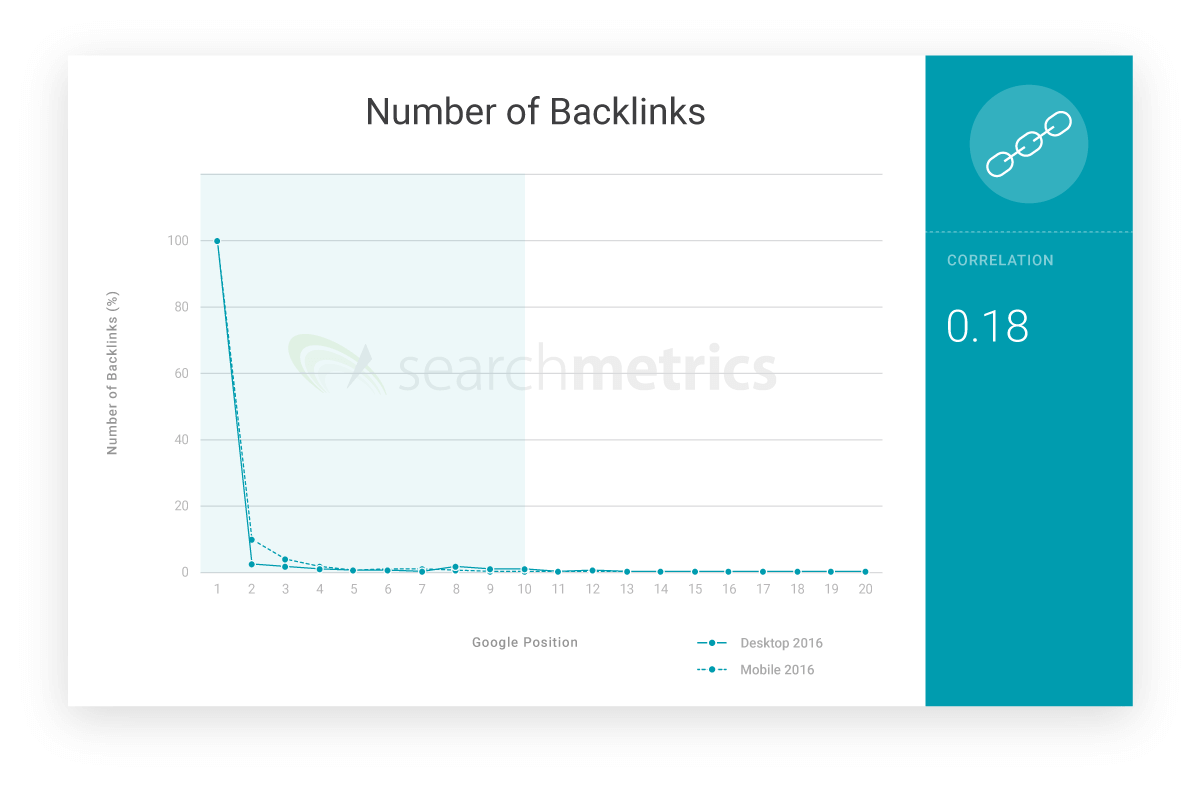

Liens-retour

La quantité de liens-retour d’un site Web reste en corrélation avec le référencement parmi les résultats de recherche. Dans le cadre de l’optimisation naturelle, le placement de liens perd tout de même en importance. Selon Searchmetrics, le profil de liens d’un site Web n’est plus un des critères principaux pour déterminer le référencement, mais seulement un critère parmi d’autres.

Google est capable de détecter les contenus de qualité grâce aux ensembles sémantiques compris dans un texte, et grâce aux signaux des utilisateurs. Le profil de liens-retour en tant que signe de qualité prend donc moins d’importance. Si l’importance des liens décroît, il convient pour les webmasters de se questionner en quoi l’offre en matière de contenu de leurs pages d’atterrissage peut offrir une valeur ajoutée aux visiteurs.

Il n’est pourtant pas encore à craindre que l’importance du profil de liens-retour disparaisse de l’algorithme de Google, comme le confirment les résultats de l’étude de Searchmetrics. Néanmoins, le profil de liens-retour n’est plus un des piliers les plus importants de l’optimisation naturelle.

« La corrélation entre les liens-retour et le référencement naturel reste établie, mais perd en importance. »

Les facteurs de référencement par rapport à leur positionnement

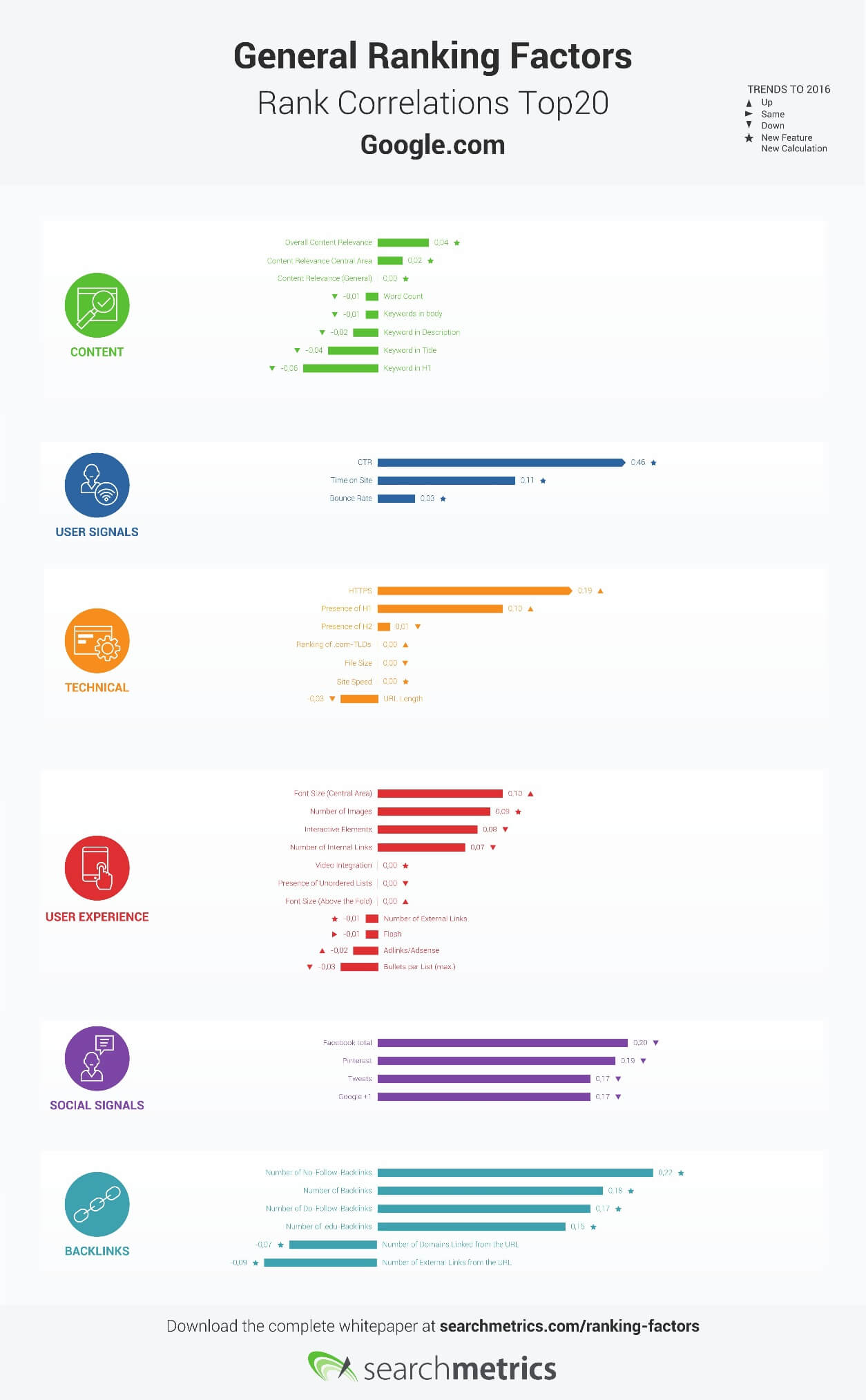

Le graphique ci-dessous dévoile la corrélation entre les critères de référencement généraux parmi les 20 premiers URLs analysés par Searchmetrics et les évolutions observées depuis l’année précédente. Les critères de référencement pour lesquels les données ont été récoltées pour la toute première fois en 2016 sont signalés par une étoile bleue.

Cliquez ici afin de télécharger le graphique « Top 20 Rank Correlations from Google.com ».

Conclusion : l’avenir de l’optimisation pour les moteurs de recherche

L’étude menée par Searchmetrics démontre qu’il existe des parallèles entre certains critères précis et un bon positionnement parmi les résultats de recherche. Ces critères ne peuvent néanmoins pas s’appliquer de manière sporadique à tous les sites Web. Les enjeux diffèrent entre les attentes des utilisateurs, de l’intelligence artificielle et en fonction des différentes branches. C’est pourquoi il convient d’éviter de tomber dans les généralités en analysant divers critères de référencement.

C’est pourquoi l’équipe de Searchmetrics a élaboré différentes études précises suite à l’analyse qui a été menée, afin que les résultats puissent correspondre aux besoins de différents secteurs. L’étude concernant les critères de référencement, et menée sur une année entière va désormais prendre en compte des mots-clés spécifiques à certains domaines d’activités (par exemple en e-commerce, santé, finance etc..). L’étude de Searchmetrics de 2016 est donc à percevoir par les administrateurs de sites Web comme un guide en matière d’optimisation naturelle réussie.